Egyre több figyelmeztetés érkezik azzal kapcsolatban, hogy a mesterséges intelligencia fényezése hamis képet mutat mindarról, ami valójában a kaszni alatt található.

A Bloomberg múlt heti Technology Summit rendezvényén külön panelbeszélgetést szenteltek a mesterséges intelligencia etikai kérdéseinek, a résztvevők pedig igyekeztek tiszta vizet önteni a pohárba az MI jövőjével kapcsolatos ígéretekről és fenyegetésekről, amelyek alkalmasak a széles nyilvánosság figyelmnek elterelésére. A Signal üzenetküldő elnöke, a Credo AI alapító vezérigazgatója és a Distributed AI Research Institute kutatási igazgatója egyetértett benne, hogy a mesterséges intelligencia nem varázslatos és nem is teljesen automatizált dolog, ezzel szemben sokkal tolakodóbb, mint amit a legtöbb ember látszólag képes felfogni.

A valóság ezek szerint nem teljesen illeszkedik az MI-ről szóló jelenlegi narratívához, amennyiben világszerte céges alalmazottak tömegeinek a munkájára van szükség, hogy a technológia bármilyen mértékben működjön. Valójában ők végzik az adatok címkézését, míg a kirakatban szereplő cégvezetők (így a rendezvényen szintén fellépő Sam Altman és Emad Mostaque az OpenAI és a Stability AI részéről) csodálatos, maguktól működő rendszerekről beszélnek. Ez azonban a látszat, és az egész mögött rengeteg emberi munka van – olvasható a TechCrunch összefoglalójában, melyet a lap az időközben közzétett beszélgetésről közölt.

Etikáról így nem érdemes beszélni

Márciusban ehhez hasonló álláspontot fogalmazott meg a világ egyik legnagyobb hatású nyelvésze és a kognitív tudomány úttörője, Noam Chomsky is a The New York Timesnak írt cikkében, amelyben a ChatGPT-ről szólva feltűnőnek nevezte az intelligencia hiányából fakadó erkölcsi közömbösséget, vagyis a plágiumot, az apátiát, az álláspont nélküli "autocomplete" összefoglalásokat és a felelősség áthárítását a rendszer alkotóira. Szerinte az ilyen modellek szükségszerűen egyszerre termelik az igaz és valótlan, etikus és etikátlan kimeneteket, miközben nem köteleződnek el a döntések mellett, és közömbösek a következmények iránt.

A Princetoni Egyetem idegtudományi professzora, Michael Graziano a The Wall Street Journal oldalán közölt írásában értekezett róla, hogy a jelenlegi MI-technológiákkal működő chatbotok kézenfekvő módon veszélyes szociopatává alakulnak, és valós kockázatokat jelenthetnek az emberekre. Utóbbiak a tudatosság révén fejlődtek proszociális fajjá, a gépek azonban nem feltétlenül értik a tudatos elmék interakcióját – vagyis megbuknának egy fordított Turing-teszten, ahol nekik kellene eldönteniük, hogy élő emberrel vagy egy másik géppel beszélgetnek. A professzor szerint érdemes figyelembe venni, hogy ez mivel járhat a nem túl távoli jövőben.

Maximális hatás, nulla átláthatóság

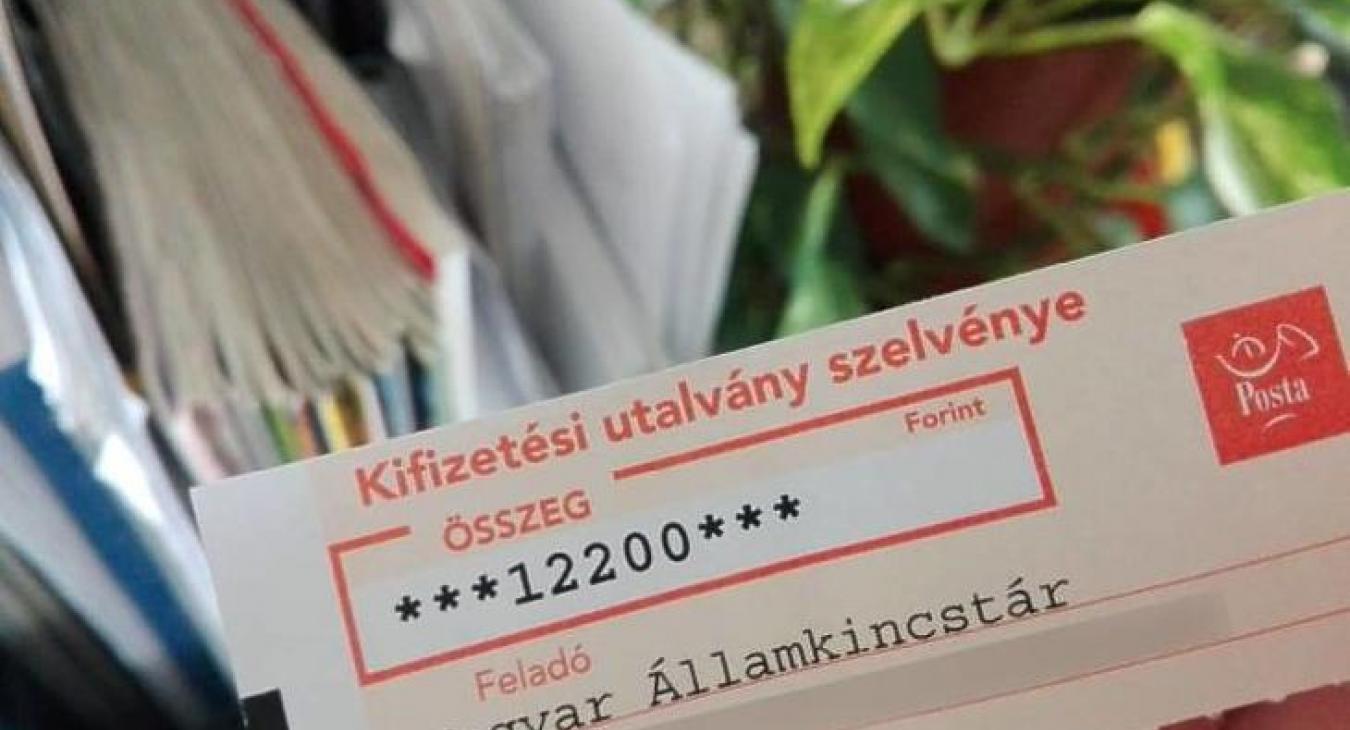

Visszatérve a Bloomberg beszélgetésére, a Signalt képviselő Meredith Whittaker abban a tekintetben is veszélyesnek tartja a ChatGPT vagy a Bard chatbotokat működtető technológiákat, hogy azok elősegíti a hatalom koncentrációját az MI-fejlesztésekben vezető szerepet játszó szervezeteknél. Szerinte sokan használják ugyan a mesterséges intelligenciát, de még többen válnak az alanyaivá, ami nem egyéni döntés kérdése. Az MI-alkalmazások úgy befolyásolják az életünket, hogy meghatározzák lehetőségeinket és az erőforrásokhoz való hozzáférésünket is, mindezt pedig olyan módon teszik, amire nincs semmilyen rálátásunk.

Közben a felhasználók akármilyen lelkesek, de egyre kevésbé értik, hogy mi történik körülöttük, és Whittaker ennek kapcsán "megfigyelési technológiaként" jellemezte a mesterséges intelligenciát, utalva a fejlesztőknél felhalmozódó óriási adatkészletek folyamatos erősítésére és kiterjesztésére. Szerinte az ilyen rendszerek megfigyelő eszközként is működnek, valószínűségi statisztikai kimenetekkel határozva meg valakinek a tartózkodási helyét, ami érdemben nem különbözik attól, mintha mondjuk a mobilos cellainformáció alapján tennék ugyanezt. És az adatoknak még csak pontosnak sem kell lenniük, hogy hatással legyenek ránk.

Nem látjuk a Skynettől az erdőt

Van, aki szerint ideje lenne újra lerakni az adatgazdaság alapjait: a virtuális valóság atyjaként emlegetett Jaron Lanier például a The New Yorker véleménycikkében reménytelennek nevezte a naponta kiadott nyilatkozatokat az MI elvi szabályozásáról, amíg nincs szó a mesterséges intelligencia feketedoboz (black box) jellegének felszámolásáról. A Meta vezető MI-tudósa, Yann LeCun szintén borzalmasnak minősítette a szabályozási elképzeléseket, sőt az ezeket támogató nagyvállalatok motivációját meglepő módon abban látja, hogy kizárják a versenyből a nyílt forrású modelleket és a szerényebb pénzből gazdálkodó startupokat.

A lényeg a Bloomberg kerekasztalának résztvevői szerint is az lenne, hogy a mesterséges intelligencia fejlődésének gyorsulásával a társadalmi hatások is egyre gyorsabban jelentkeznek, ezért az egyéni és kollektív életünk feletti önrendelkezés is könnyen lecsökkenhet egy olyan szintre, ami már egzisztenciális aggodalmakra ad okot. Mindezek alapján az öntudatra ébredő és az emberiség elpusztítására törő MI egy olyan lufi, amitől a fejlesztők látványos szabályozásokkal védenék meg az embereket, ezzel pedig elterelik a figyelmet aranybányának tekintett termékeik, így a generatív algoritmusok káros hatásairól.